| Startete: | 2009 |

| Ansprechpartner: | Ralf Reulke |

| Mitarbeiter: | Dominik Rueß, Kristian Manthey |

Kameras zur Beobachtung von öffentlichen Plätzen, Flughäfen und Gebäuden sind inzwischen allgegenwärtig. In den allermeisten Fällen werden die von den Kameras gelieferten Informationen von Menschen ausgewertet. Da Personal teuer ist, wertet üblicherweise ein Mitarbeiter das Signal vieler Kameras aus. Oft funktionieren die Kameras durch entsprechende Software auch als Bewegungsmelder. In diesem Fall wird ein Alarm ausgelöst und das Videobild auf einen zentralen Monitor geschaltet. Dies führt in der Praxis sehr häufig zu Fehlalarmen.

Keines der am Markt befindlichen Systeme ist in der Lage, Objekte zu identifizieren und Alarm nur bei bestimmten Ereignissen auszulösen. Gerade diese Funktion würde aber die Effizienz der Überwachungsanlage drastisch verbessern, die Fehlalarmquote senken und das Personal wirksam entlasten. Im Rahmen dieses Projektes wird ein System entwickelt, das mit mehreren Kameras auch ein großes Gelände überwachen und bestimmte Situationen automatisch erkennen kann. Um Objekte mit diesem System erkennen und unterscheiden zu können, ist eine 3-dimensionale Erfassung und Verfolgung der Objekte und deren Lage erforderlich.

|

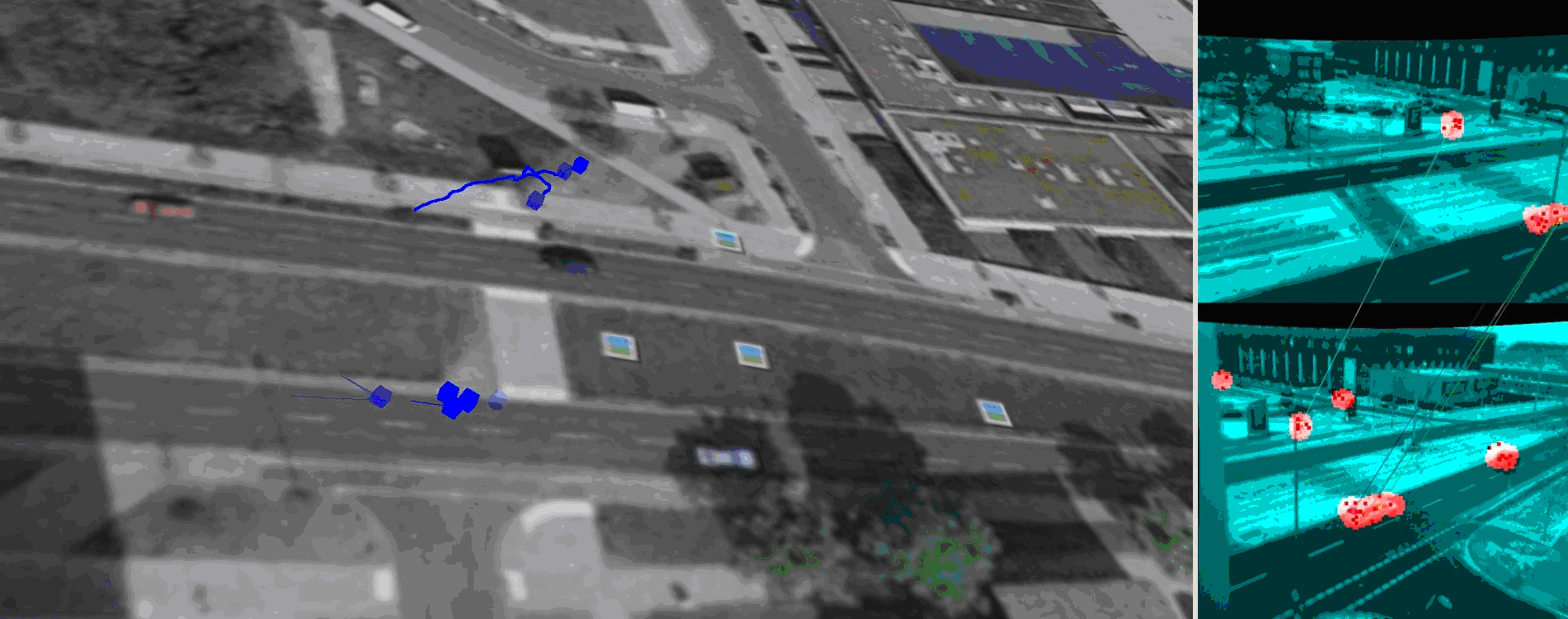

| Abbildung 1: Zwei Ansichten einer Kreuzung mit einer großen Stereo-Basis (rechte Seite). Auf der linken Seite ist die Rekonstruktionsansicht dargestellt, mit einer 3D-Rekonstruktion von Features der beiden Eingangsbilder. Außerdem sieht man die Trajektorie eines Fußgängers. |

Für die 3-dimensionale Erfassung der Objekte müssen zeitliche und räumliche Korrespondenzen zwischen den Bildern ermittelt werden. Es wurde die Eignung verschiedener Verfahren zur Feature-Detektion/Beschreibung (SIFT, SURF, ASIFT, SUSAN, MSER, Harris-Corner, MSER und andere) für Wide-Baseline Szenarien sowie zur 3D-Multikamera-Rekonstruktion untersucht. Als geeignet hat sich ein MSER-Detektor herausgestellt, bei dem für jeden gefundenen Bereich ein Ellipsen-Fit durchgeführt und anschließend ein Deskriptor (ähnlich dem SIFT-Deskriptor) berechnet wird. Unter Zuhilfenahme der Epipolargeometrie kann so die räumliche Lage sowie das Zentrum dieser Bereiche berechnet werden.

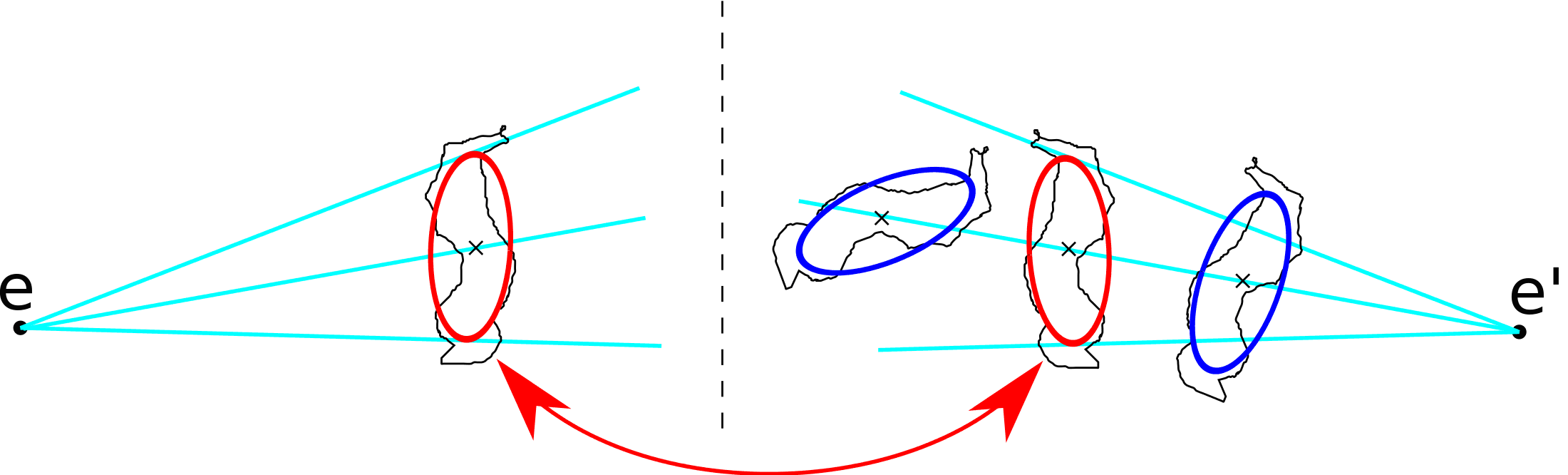

Im Rahmen des Projektes wurden verschiedene Untersuchungen zu diesen Features durchgeführt. Es wurden Erweiterungen der Epipolargeometrie hinzugefügt, welche es erlauben, Features noch robuster gegen Fehldetektion zu matchen. Dies wird in Abbildung 2 verdeutlicht.

|

| Abbildung 2: Zusätzliche Epipolar-Constraints. Mithilfe der Ellipsen Tangenten als Epipolarlinien wird das Feature-Regionen Matching verbessert. |

Wird eine Feature-Detektion innerhalb einer “intelligenten” Überwachungskamera umgesetzt, so kann das Datenvolumen, welches zu einem zentralen Server übertragen werden muss, signifikant reduziert werden. Die Trajektorien der Objekte sollen ausgehend von der 3D-Szene und dem Ergebnis der Objektsegmentierung extrahiert werden. Dabei sollen Kalman- oder Particle-Filter angewendet werden, um die verrauschten Daten zu korrigieren und um Vorhersagen für den aktuellen Zeitschritt treffen zu können. Zusätzlich wird untersucht, ob Features die Objektverfolgung unterstützen können, indem diese bereits mit entsprechender Hardware in der Kamera selbst verfolgt werden. In der Objektverfolgung sollen neben den Trajektorien Zustandsgrößen ermittelt werden, mit denen später eine Klassifikation vorgenommen werden kann. Die Szene soll damit anschließend in “normal” oder “unnormal” eingestuft werden, um schlussendlich qualifiziertes Personal zu unterstützen.

© 2026 - Computer Vision, Institut für Informatik, HU Berlin - - Impressum