Die Computer Vision umfasst sämtliche Aspekte des automatischen Rechnersehens.

Sie ist ein Teilgebiet der Informatik, welches sich mit vielen anderen Disziplinen

überschneidet, u.a. Künstliche Intelligenz, Maschinelles Lernen, Physik,

Mathematik, Robotik, Signalverarbeitung, Bildgebung und Neurobiologie. Die komplette

thematische Fülle des Fachbereichs soll hier nicht umfassend erläutert

werden, wir geben hier nur einen Einblick in die thematischen Lehr- und Forschungsschwerpunkte

der Arbeitsgruppe "Computer Vision", des Instituts für Informatik.

Insbesondere den StudentInnen, die an Vorlesungen oder Seminaren in diesem Gebiet

interessiert sind oder vielleicht auch mit dem Gedanken spielen, auf diesem Gebiet

eine Arbeit zu schreiben, soll diese Zusammenfassung einen Einblick geben.

Eigenschaften einer Kamera

Kalibrierung (Inkl. Innere Orientierung)

Am Anfang steht das Bild. Doch das ist bereits einen Schritt zu weit gedacht. Vorher

stehen die physikalischen Eigenschaften der CMOS- oder der CCD-Kamerasensoren,

welche zuständig für die Bildgebung sind. Versteht man diese

(radiometrischen) Eigenschaften einer Kamera, kann man verschiedene Phänomene

der Abbildung erklären und sich zunutze machen. Dazu gehört zum Beispiel

der wichtige Effekt der "Vignettierung", welcher den Abfall der Helligkeit

zum Rand hin beschreibt. Unser Projekt "Schnelles Photolumineszenz Messverfahren für die Inspektion von Solarmodulen mittels Deep-Depletion CCD Kameras" behandelt solche Aspekte.

Auch ist es für viele Anwendungen wichtig zu wissen, wie genau ein Strahlengang

in seiner Geometrie verläuft. Hier werden Merkmale behandelt, welche

z.B. für die bekannten Effekte der "Verzeichnung" verantwortlich sind

(z.B. die "Kissenverzeichnung"). Das spiegelt sich vor allem in Geraden wieder,

welche in dem Bild nun eben nicht mehr gerade sind.

Um mit diesen Eigenschaften der Kamera umgehen zu können, werden beschreibende

Modelle benötigt. Den Prozess der Bestimmung der

nötigen Modellparameter für eine bestimmte Kamera nennt man Kalibrierung.

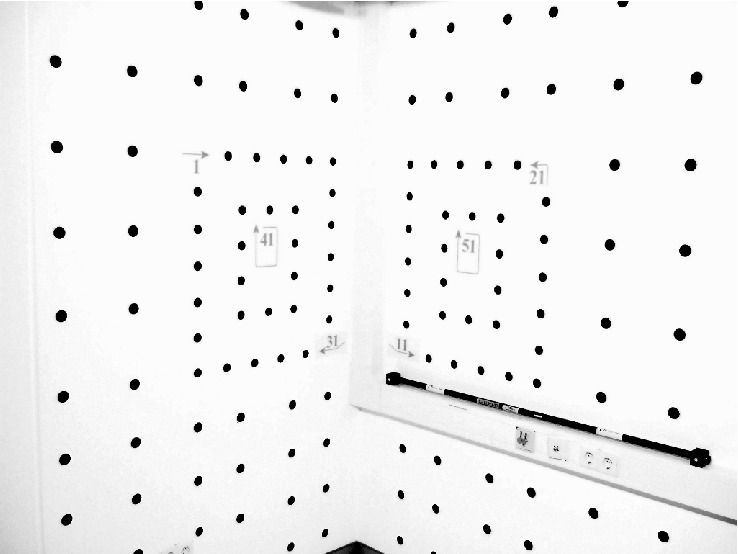

In der Regel werden hierfür hochgenau vermessene Referenzengeometrien abfotografiert,

sodass man aus mehreren solchen Aufnahmen - immer in verschiedenen Posen - die Parameter

der inneren Orientierung bestimmen kann. Siehe

"Orientierungsbestimmung von Kameras für Verkehrsapplikationen".

Abbildungsprozess

Die Abbildung der realen Welt in ein Bild kann auf verschiedene Weise beschrieben werden.

Am einfachsten ist das "Lochkameramodell". Hierbei wird ein (reflektierter) Strahl

beschrieben, welcher ein unendlich kleines Loch durchquert und dahinter auf den Bildsensor

trifft.

Man bekommt also aus der Menge der Strahlen, die dieses Loch (= Brennpunkt) durchqueren ein

zweidimensionales Abbild der dreidimensionalen Welt, welches zudem im Brennpunkt gespiegelt wird.

Da echte optische Systeme leider nicht exakt dem Lochkameramodell genügen, kann man

auf Modelle zurückgreifen, welche die radiometrischen und geometrischen

Abweichungen von diesem Modell korrigieren.

Benutzt man also eine kalibrierte Kamera, kann man das Eingangsbild entsprechend normalisieren

und von diesem Zeitpunkt an das Lochkameramodell verwenden.

Alternative Kamerageometrien

Jeder kennt die klassische Zoom-Kamera. Man hat einen "Weitwinkel" und einen "Zoom".

Diese Kameras entsprechen noch am ehesten dem Lochkameramodell und man bekommt die Abbildungsfunktion

mithilfe der klassischen, geometrischen Kalibrierung gut in den Griff.

Aber schon bei extremeren Optiken, wie z.B. "Fisheyes" ist es sehr schwer mit dem

klassischen Abbildungsmodell einen Strahlengang zu verfolgen.

Noch schwieriger wird es, benutzt man sogenannte katadioptrische Systeme. Diese

verwenden Spiegelsysteme und erlauben so z.B. komplette Draufsichten einer Szene, mit

nur einer Kamera darzustellen.

In dem Projekt

"Beschreibung alternativer Abbildungsgeometrien"

werden solche Geometrien untersucht.

|

| Abbildung: Beispiel einer katadioptrischen Linse. Man erhält hierbei eine Rundumsicht einer Szene. (Bild anklicken für größere Ansicht) |

Stereorekonstruktion

Übersicht

Doch wozu benötigt man die ganzen Abbildungsmodelle, Kalibrierungen und überhaupt

den ganzen Aufwand? Eine sehr wichtige Anwendung, die auf der Kenntnis exakter Strahlengänge beruht ist

die Stereorekonstruktion.

Hat man nun zwei Kameras (oder noch mehr), ist es prinzipiell möglich die 3D-Koordinaten eines Punktes,

welcher in beiden Kameras zu sehen ist, zu berechnen.

Dafür benötigt man aber die genaue Kenntnis der jeweiligen Kamerablickrichtung, wie auch deren

genaue Position.

Damit kann nun, mithilfe einer "Rückwärtsverfolgung" der beiden Strahlengänge, ein Schnittpunkt

im Raum bestimmt werden, welcher schlussendlich dann der Punkt ist, den beide Kameras abgebildet haben.

Kalibrierung (Äußere Orientierung)

Unter Zuhilfenahme von vermessenen Punkten kann die Kameraposition und Blickrichtung sehr

genau bestimmt werden (Position und Richtung in einem Welt-Koordinatensystem).

Oftmals ist es aber nicht immer möglich, solche Punkte zu vermessen.

Dann kann man auf Verfahren zurückgreifen, welche die relative Orientierung

zweier oder mehr Kameras bestimmen. Relativ heißt in diesem Fall,

dass man ein Koordinatensystem manuell festlegt und in diesem System dann

die Orientierung der Kameras relativ zueinander bestimmt.

Hierbei gibt es manuelle und automatische Verfahren.

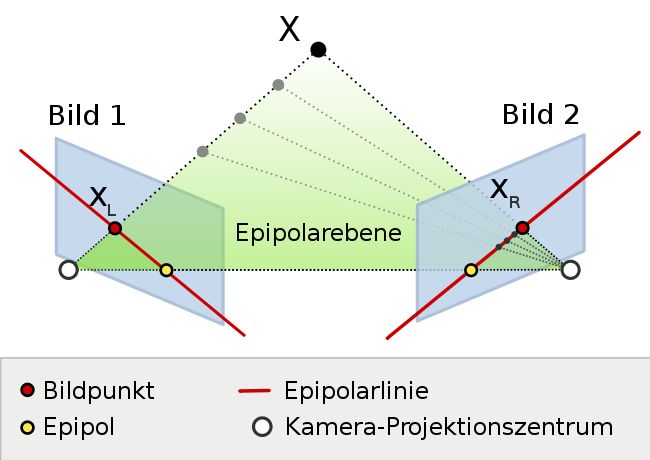

Epipolargeometrie

Oft wird die relative Orientierung der Kameras durch die Fundamentalmatrix beschrieben.

Hat man einen Punkt in einem Bild der Kamera A, kann man bei Kenntnis dieser Fundamentalmatrix

eine Linie im Bild der Kamera B bestimmen, auf welcher derselbe Punkt liegen muss (da es

sonst mathematisch nicht derselbe Punkt sein kann).

Das ist das Grundprinzip der Epipolargeometrie. Man hat also eine Einschränkung der

Positionen der Abbildung eines 3D-Punktes in verschiedenen Kameras.

Auf diesem Prinzip beruhen viele weitere Verfahren. Insbesondere automatische Punktzuordnungs- und

Rekonstruktionsverfahren sind darauf angewiesen.

In unserem Projekt "3D-Überwachung mittels synchronisierter Kameras und Wide-Baseline-Stereo" wird auf diese Thematik weiter eingegangen.

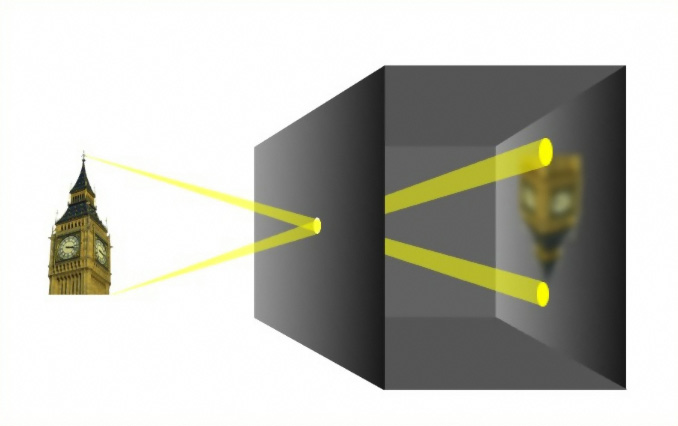

|

| Abbildung: Illustration der Epipolargeometrie. Quelle: Arne Nordmann, Nutzungsrechte: Creative Commons-Lizenz. (Bild anklicken für größere Ansicht) |

Dichte Stereorekonstruktion

In bestimmten Fällen ist es möglich, nicht nur bestimmte Punkte zu rekonstruieren, sondern

(fast) jeden Bildpunkt. Das Ergebnis ist eine dichte Tiefenkarte ("Disparitätenbild").

Es ist Gegenstand der Forschung, dies in Fahrerassistenzsystemen bei Autos einzusetzen.

So können durch die Detektion und die Vorhersage möglicher Bewegungspfade von Objekten,

wie zum Beispiel Fußgänger, mögliche Kollisionen frühzeitig erkannt werden.

Weitere Themenschwerpunkte

Photogrammetrie

Die Photogrammetrie, ein Teilgebiet der Fernerkundung, beschreibt verschiedene Messverfahren

zur Bestimmung der räumlichen Lage oder der dreidimensionalen Form. Dabei steht die Exaktheit im Vordergrund,

manchmal wird dies durch manuelle Auswertung erreicht.

Klassische Anwendungsbeispiele sind die Luftbildphotogrammetrie, welche als Ziel

die Erstellung von digitalen Geländemodellen, Orthoansichten, etc. hat, sowie die Nahbereichsphotogrammetrie,

bei der z.B. industrielle Messtechnik, Unfallaufnahme, Vermessungen in Archäologie/Architektur bekannt sind.

Die Photogrammetrie und die Computer Vision überlappen sich sehr stark, wobei oft zwei verschiedene

mathematische Modelle die gleiche Eigenschaft beschreiben.

Die Kombination des Wissens beider Richtungen kann zu verbesserten Ergebnissen führen. Auch sind

einige nützliche Ergebnisse der doch recht alten Photogrammetrie, noch immer nicht komplett in der jungen Computer

Vision zu finden. Das zeigt sich darin, dass oft "neue" Verfahren entwickelt werden, welche in der

Photogrammetrie bereits länger bekannt sind.

Vorverarbeitung

Bilder sind nicht immer so gespeichert, wie man sie auf einem Monitor sehen kann.

So liefern Farbkameras oftmals zunächst Grauwertbilder, bei dem ein Vierer-Block von

Bildpunkten, einzelne Farbkanäle beschreibt. Dies ist fast immer ein sogenanntes "Bayer-Pattern",

worin (wegen der Dominanz der Farbe Grün) zwei Bildpunkte für grün stehen und je einer für

rot und blau.

An manchen Anwendungen ist es wichtig, nur Bereiche eines Bildes zu betrachten, in der Bewegung existiert.

Hier wird oft eine Hintergrundextraktion bzw. Hintergrundschätzung

eingesetzt.

Viele weitere spannende Themen in diesem Bereich sind in der generellen Mustererkennung zu finden.

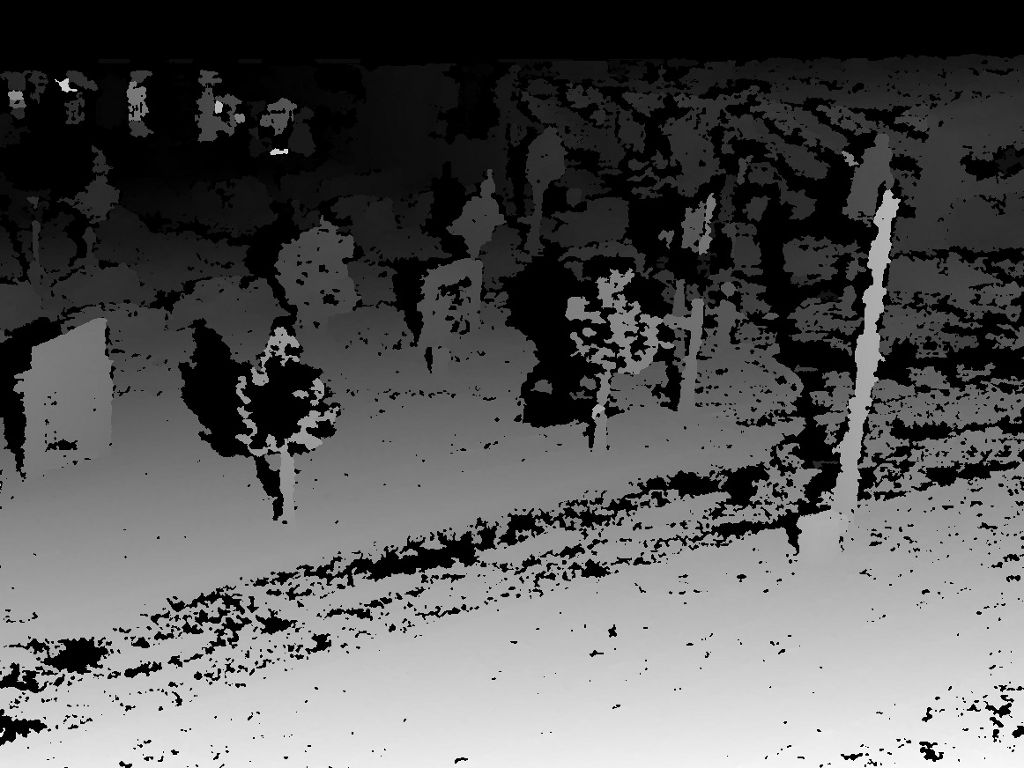

|

| Abbildung: Beispiele einer Hintergrundschätzung. Links eines der Eingangsbilder und rechts eine Ausgangsbild, das den bewegten Vordergrund maskiert. (Bilder anklicken für größere Ansicht) |

Nicht-optische Systeme

Es gibt eine ganze Reihe von alternativen, nicht-optischen Systemen, welche ebenfalls 3D-Rekonstruktionen

bewerkstelligen. Dazu gehören Phasenmessgeräte, wie zum Beispiel das PMD ("Photonic Mixer Device"),

welche die Lichtlaufzeit messen und daraus Rückschlüsse auf die Tiefe ziehen.

Auch sind generell laserbasierte Geräte oft sehr genau in der Bestimmung der Tiefe von Punkten oder ganzer

Oberflächen von Objekten.

Man nennt licht-basierte Systeme auch oft LIDAR (Light Detection And Ranging)-Systeme.

Objektverfolgung und Klassifikation

Gerade in der Robotik, wie aber auch in Verkehrsystemen, ist es oft wichtig, dass man

den Pfad von Objekten über die Zeit verfolgen kann. Damit kann man

bestimmte Bewegungseigenschaften ableiten, sowie generell Situationsanalyse betreiben (z.B. "entspricht

Situation X einer Situation, wie ich als Computer sie kenne?" oder auch "Wieviele

Fahrzeuge biegen eigentlich hier links ab? Und wie viele davon sind PKW?", uvm...).

Ein anderes Beispiel ist der "Solartracker", welcher die Bahn der Sonne verfolgt

und Solarmodule mit Nachführung so steuert, dass sie immer die optimale Position zur Sonne

behalten.

Dabei werden Positionsdaten von Objekten in verschiedenen Zeitschritten einander zugeordnet.

Man erhält Trajektorien von Objekten.

Diese Trajektorien sind i.d.R. mit Messrauschen behaftet, welches dafür verantwortlich ist,

dass die Bewegung recht "eckig" erscheint.

Ursprünglich vom Militär entwickelt, werden hier oft Kalman-Filter eingesetzt,

welche u.a. mit der Kenntnis über das Bewegungsmodell der Objekte, die Trajektorie

"glätten" können.

Außerdem spielt hier die Thematik der Objektklassifikation eine wichtige Rolle, wozu

auch die Lageerkennung der Objekte gehört. Man will wissen, was für ein Typ

ein Objekt X ist ("ist es PKW, Radfahrer, Fußgänger"?, "Läuft

die Turbine normal oder hat sich etwas an dem Vibrationsverhalten geändert?",

"Ist das produzierte Teil fehlerfrei oder hat es einen Materialfehler?", uvm...)

|

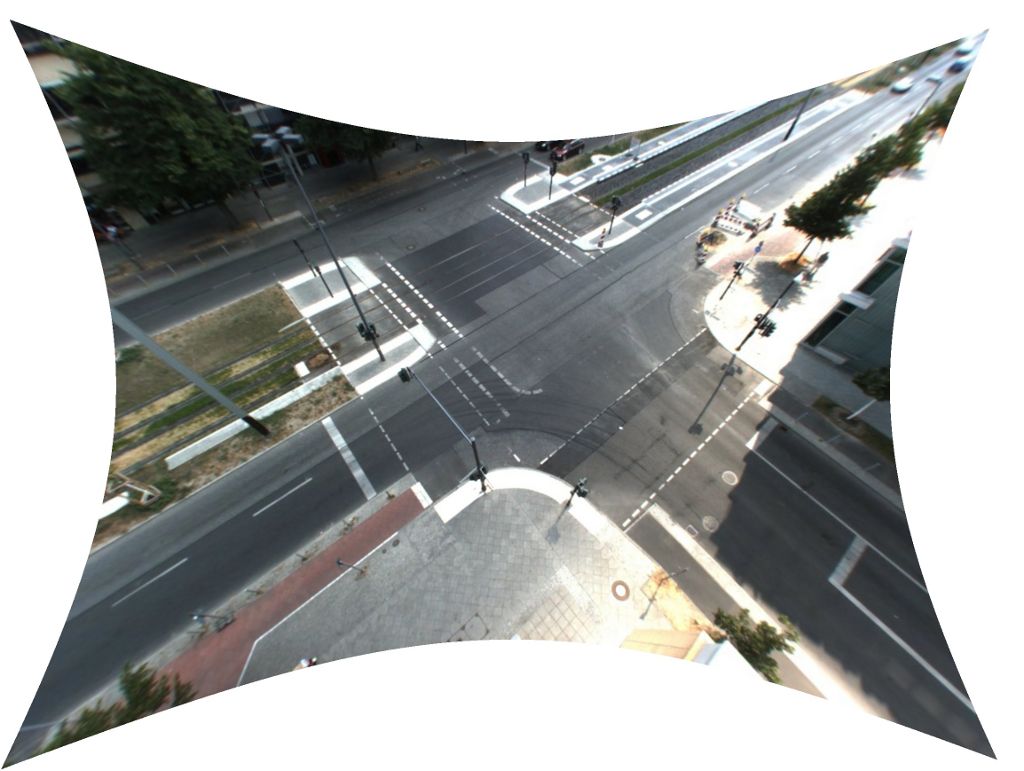

| Abbildung: Beispiel eines Objektverfolgungsergebnisses. Man erkennt die Trajektorien einiger bewegter Objekte. (Bild anklicken für größere Ansicht) |

Zusammenfassung

Wir hoffen, dass wir in dieser kurzen Zusammenfassung Dein Interesse wecken konnten und Dich eventuell

sogar für eine Teilnahme an einer der Vorlesungen oder Seminare begeistern konnten.

Auch freuen wir uns natürlich über Kontaktanfragen zu Studien-, Diplom-, Bachelor-, Master- und

Doktorarbeiten, sowie generell über sonstige Anfragen.

Bitte hierzu Prof. Dr. rer. nat. Ralf Reulke kontaktieren.

Bei Fragen oder Anmerkungen zu diesem Text bitte Dominik Rueß oder Kristian Manthey anschreiben.

© 2024 - Computer Vision, Institut für Informatik, HU Berlin - - Impressum